L'AI favorirà i crimini informatici? E la progressiva diffusione degli “agenti AI” di certo non aiuta

Da tempo un numero crescente di settori economici è fortemente digitalizzato e parte di un sistema internazionale complesso, in cui infrastrutture, servizi o attori pubblici e privati dipendono molto gli uni dagli altri. All’interno di questo scenario, ogni possibile falla tecnologica può essere potenzialmente sfruttata per effettuare attacchi informatici: le conseguenze di questi eventi, però, non si limitano più al semplice furto di dati, ma mettono in pericolo il funzionamento di servizi essenziali per la vita delle persone. È anche per questo che il fenomeno della criminalità informatica viene sottovalutato sempre meno da governi e istituzioni. Oggi i cyber attacchi possono coinvolgere ospedali, aziende di trasporto, reti energetiche o il settore della grande distribuzione, tra le altre cose. Ad esempio, come segnala il Financial Times, lo scorso anno sono state colpite le infrastrutture tecnologiche dell’azienda britannica Synnovis, che fornisce servizi di analisi del sangue per il sistema sanitario del Regno Unito. A causa dell’attacco, sono stati cancellati o rinviati migliaia di esami medici e interventi programmati. In almeno due casi, l’evento ha avuto conseguenze dirette sulla salute dei pazienti. Tutto ciò si verifica anche perché molte grandi aziende tendono ad affidare la gestione IT – cioè il controllo e la gestione delle proprie risorse informatiche – a fornitori esterni. La filiera, dunque, può essere relativamente lunga e distribuita: in questo contesto, i collegamenti tra le diverse infrastrutture digitali possono presentare punti deboli, che i team di hacker non di rado sfruttano con relativa facilità per aggirare i sistemi di sicurezza ed effettuare attacchi informatici mirati.

@worldeconomicforum A business falls victim to #cybercrime every 39 seconds. #AI is making these attacks more convincing than ever. Hear from INTERPOL Director of Cybercrime Neal Jetton and learn more in our newly launched report, the Global Cybersecurity Outlook 2025, using the link in our bio. #WEF25 #Cybersecurity25 original sound - World Economic Forum

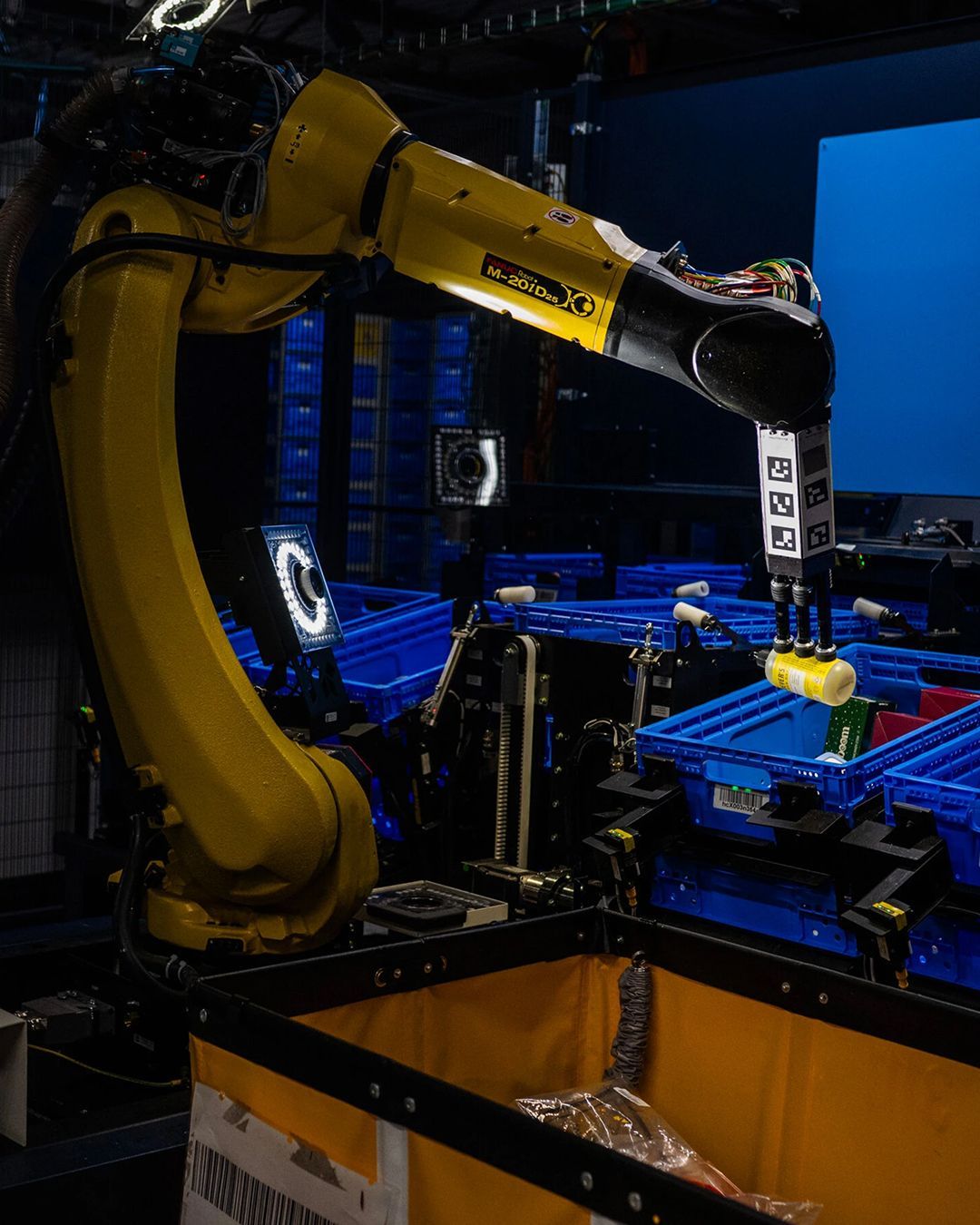

C’è un altro fattore, poi, da tenere in considerazione: la crescente disponibilità di strumenti basati sull’intelligenza artificiale ha ridotto drasticamente le competenze tecniche necessarie per portare a termine crimini informatici. Un esempio è WormGPT, un modello linguistico lanciato nel 2023 e sviluppato esplicitamente per scopi criminali. A differenza di sistemi simili come ChatGPT, che includono meccanismi di protezione per limitare possibili usi impropri, WormGPT non ha filtri etici o di sicurezza: è progettato per non bloccare richieste dannose, come generare malware, email di phishing o istruzioni per attacchi informatici. L’obiettivo dichiarato dei suoi sviluppatori era offrire un tool destinato a utenti intenzionati a sfruttare l’intelligenza artificiale per automatizzare crimini informatici. In questo campo, ciò che potrebbe rappresentare una svolta ancora più preoccupante è la diffusione dei cosiddetti agenti AI, cioè sistemi capaci di svolgere azioni complesse in autonomia per conto degli utenti. Mentre i chatbot tradizionali si limitano a rispondere a comandi o svolgere compiti specifici, gli agenti AI sono progettati per agire in modo autonomo, adattarsi all’ambiente digitale in cui operano e perseguire obiettivi in maniera continuativa. Il loro potenziale per fini illeciti è quindi enorme.

Cybercriminals are now using commercial AI models like xAI’s Grok and Mistral’s Mixtral to build and sell jailbroken tools like WormGPT. These are being wrapped, reprogrammed, and sold on forums like BreachForums as "uncensored AI assistants."#AIsecurity #LLM pic.twitter.com/K3ykLiJLJV

— ShiftSix Security (@Shift6Security) June 18, 2025

Come si legge sul Financial Times, la stessa Microsoft sostiene che nei prossimi due anni la diffusione degli agenti AI aumenterà sensibilmente, passando da una fase sperimentale a un utilizzo più consapevole da parte degli utenti, con implicazioni significative anche per la sicurezza informatica. La progressiva circolazione di agenti AI e i rischi legati al loro uso illecito rendono la governance di queste tecnologie un tema cruciale. Di fronte a questo scenario, non aiuta – come segnala Wired Italia – i ritardi accumulati e il probabile rinvio dell’entrata in vigore dell’AI Act, la proposta di regolamento europeo che disciplinerà lo sviluppo e l’utilizzo dei sistemi di intelligenza artificiale nel continente. «La velocità dell’innovazione nel campo dell’intelligenza artificiale ha raggiunto livelli straordinari. Tuttavia, l’impatto di questi progressi sulla sicurezza globale dipenderà in larga misura dalle dinamiche geopolitiche. Le crescenti tensioni tra Stati Uniti e Cina, la capacità dell’Unione Europea di affermare una vera “sovranità digitale” di fronte al predominio tecnologico americano e cinese, e la volontà della Russia di continuare a tollerare la presenza di gruppi criminali e di spionaggio sul proprio territorio: sono queste le sfide chiave che plasmeranno il futuro della sicurezza in rete», avverte il Financial Times.